L’ATTO DEL VEDERE COSTITUISCE IL NOSTRO RAPPORTO PRIMARIO con il mondo, non ci dobbiamo meravigliare perciò se un’analisi dei processi visivi può mostrare una complessità teorica che conduce direttamente ai problemi spinosi che si intrecciano al confine tra neuroscienze, intelligenza artificiale ed epistemologia cognitiva. L’analisi della visione è una guida verso una teoria naturale della conoscenza, in accordo con l’idea di Gregory Bateson: “Se vogliamo comprendere i processi mentali, guardiamo all’evoluzione biologica”. “Teoria” e “vedere” del resto hanno una radice etimologica comune, in entrambi i casi siamo chiamati infatti a operare una serie di scelte interpretative senza le quali non c’è conoscenza. Tra mente e mondo non c’è un taglio netto di cartesiana chiarezza, osservatore ed osservato si riflettono e si definiscono l’un l’altro in una circolarità di ricorsioni semiotiche infinite che è l’essenza stessa della conoscenza e in cui entra in gioco l’irriducibile soggettività dell’osservatore.

Quando uno stimolo visivo raggiunge l’occhio, dopo circa 200 millisecondi vengono attivate le risorse neuronali della corteccia visiva (CV) per analizzare le informazioni di riconoscimento che riguardano struttura, movimento e colore. Molte “agenzie corticali” diverse si mettono al lavoro secondo un criterio cooperativo di sincronizzazione, ed una volta individuato il pattern d’ingresso l’informazione passa alla corteccia prefrontale (CPF), dove viene valutata per circa 600 millisecondi per attivare poi specifiche aree motorie e linguistiche necessarie alla risposta dell’organismo.

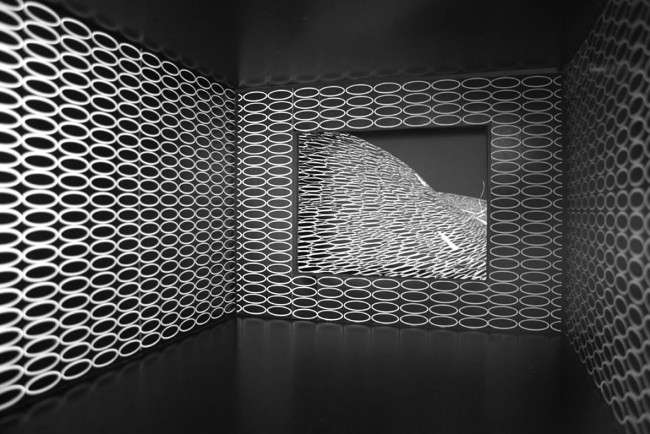

Quanto di questo processo può essere “catturato” da un algoritmo e “zippato” in un programma? Gli studiosi di IA hanno dovuto affrontare enormi difficoltà nel modellare la prima fase della percezione, quella della CV. Ogni stimolo viene infatti distribuito su una miriade di fibre specializzate nei vari aspetti del riconoscimento per un’elaborazione collettiva unitaria attraverso il feature binding, ossia la combinazione sintonizzata di miriadi di impulsi provenienti da moduli neuronali diversi dai quali la percezione emerge come un fenomeno olistico.

In termini computazionali questo è un classico problema di complessità algoritmica, una misura della quantità di informazione spaziale e temporale che un sistema artificiale deve elaborare. I metodi simbolici, basati su modelli precedentemente memorizzati nella macchina, hanno trovato ben presto, dietro alla grande varietà dei problemi tecnici, un limite generale che investe l’intera filosofia algoritmi dell’IA, il problema della “logica chiusa”: un approccio puramente algoritmico ha successo soltanto in un mondo in cui sintassi e semantica coincidono, come gli scacchi o i sistemi esperti. La visione artificiale ha ottenuto infatti successi nel riconoscimento di forme semplici con dinamiche elementari.

Maggiori vantaggi nel riconoscimento di pattern sono stati ottenuti con le reti neurali, capaci di elaborazione parallela e distribuita di ispirazione biomorfa. Anche questa classe di analizzatori statistici di dati hanno però un problema comune con i modelli simbolici dell’IA, quello del Symbol Grounding Problem, ossia del significato del pattern identificato. Insomma, l’idea di poter comprimere la complessità della percezione visiva in un meccanismo basato sulla mera elaborazione di informazione sintattica è destinato a scontrarsi con la soglia della complessità semantica. In sintesi, i metodi computazioni possono risolvere parte del problema del “guardare e riconoscere” ma non quello più ampio del “vedere”.

Quando studiamo qualche aspetto del mondo partiamo sempre da un modello, un insieme di ipotesi che ci permette di estrarre informazione organizzata e semanticamente significativa (in breve, una comprensione!) dalla varietà dei dati estratti dall’esperienza. Un modello può essere considerato come un gioco di domande mirate che rivolgiamo al sistema studiato e sul quale basiamo il dialogo con la natura. Cambiando modello cambia l’asse osservatore-osservato e per sistemi sufficientemente complessi – come quelli biologici e cognitivi – questo significa fare domande diverse ed ottenere risposte diverse! Un modello è semplicemente una prospettiva concettuale attraverso la quale osserviamo il mondo. Possiamo perciò definire la complessità semantica come il numero di modelli utilizzati per studiare un sistema nei suoi diversi aspetti. In termini computazionali, questo significa che per studiare un sistema complesso abbiamo bisogno di cambiare i nostri codici e che l’autentica comprensione di un sistema naturale nasce dall’uso integrato e non esclusivo di più prospettive modellistiche.

Quando valutiamo il modello di un fenomeno non ci basiamo soltanto sui dati bruti dell’esperienza, ma facciamo ricorso ad un bagaglio teorico stratificato culturalmente che ci aiuta a valutare e selezionare. In modo analogo, il processo di valutazione della percezione visiva chiama in gioco la memoria, le esperienze pregresse, le conoscenze e gli scopi dell’osservatore. Senza questi elementi non c’è visione. È possibile dimostrare che una percezione, per essere registrata come esperienza cosciente, deve stabilizzarsi mediante un feed-back adattativo tra stimoli in entrata e strutture cognitive pregresse dell’osservatore da cui scaturisce la risposta collettiva dei neuroni (ART: Adaptative Resonance Theory).

Mentre gli stadi iniziali della visione nella CV possono, in linea di principio, essere descritti come un processo di organizzazione di informazione sintattica, come avviene nella raccolta sperimentale dei dati in un esperimento, la visione cosciente si realizza soltanto dopo una valutazione “teorica” dei dati percettivi, relativa alle rappresentazioni del mondo prodotte dal soggetto ed alla sua dimensione semantica.

Lo spazio semantico non è predefinito e chiuso, ma subisce continuamente transizioni dell’apertura logica, con emergenza di nuovi paesaggi cognitivi. Esempi ormai famosi vengono dallo studio della percezione olfattiva nelle locuste e nei conigli. Nel primo caso si osserva che la sequenza temporale di attività neuronali che codifica un odore non varia in successive presentazioni dello stesso stimolo, mentre nei conigli ad uno stesso stimolo corrispondono sequenze diverse, segno che l’apertura logica del coniglio cambia con ogni singola esperienza, modificando il suo repertorio di significati.

Arriviamo così a comprendere l’importanza cognitiva di quella coscienza che era stata espulsa dalle vocazioni fisicaliste della prima scienza cognitiva come “un fumo che esce dal cervello” (F. Varela). Al contrario, l’analisi comparata dei processi di percezione e dei procedimenti di costruzione teorica, mostrano il ruolo cruciale della soggettività nella produzione di conoscenza: senza dinamiche dello spazio semantico, senza scelte da parte dell’osservatore, non è possibile alcuna rappresentazione del mondo, a partire dall’atto apparentemente elementare della percezione. L’epistemologia della complessità ridefinisce così la scienza come arte della conoscenza (P. Feyerabend), mentre l’antica opposizione scienza/arte sfuma nei confini frattali delle comuni strategie cognitive che situano la fecondità del nostro dialogo con il mondo oltre la soglia dell’informazione sintattica, nel gioco infinito della creatività e dell’interpretazione.

Ignazio Licata